Med AI kommer svårigheterna med att säga vad som är rätt och fel. Vi människor tar våra beslut genom flera olika faktorer och erfarenheter. Dessa skiljer sig från människa till människa. Men vilken av dessa ska lära maskinerna?

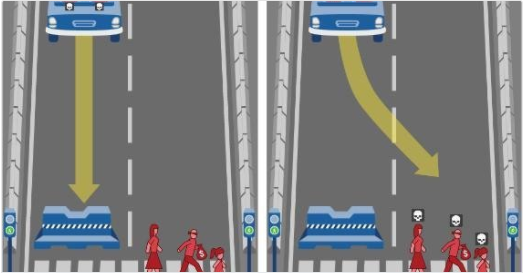

Det senaste exemplen med självkörande bilar som har kört på människor eller valt en helt felaktig väg in i en bergvägg. Gjorde intelligensen i bilen rätt val? Det blir väldigt svårt att följa en strikt moral. Hur lyckas du med dina beslut. Är du ”klokare” än den självkörande bilen? MIT:s test The Moral Machine: